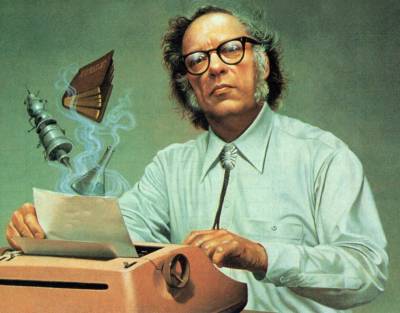

Le tre leggi della robotica (e la legge zero) di Asimov

Pubblicate per la prima volta nel 1942 nel racconto intitolato Circolo vizioso sulla rivista di fantascienza Astounding Science-Fiction, le tre leggi della robotica di Isaac Asimov nascono dalla convinzione dello scrittore che, se progettati bene e non utilizzati impropriamente, i robot non potessero essere pericolosi o rischiosi per l’uomo.

Per sostenere la sua idea, quindi, Asimov introdusse nei suoi racconti alcuni principi di sicurezza (la prima legge della robotica), di servizio (la seconda legge della robotica) e di autoconservazione (la terza legge della robotica) con i quali si regolamentava il comportamento dei robot positronici (robot dotati di cervello positronico).

Ecco cosa dicono le tre leggi della robotica:

1) prima legge: un robot non può recar danno a un essere umano né può permettere che, a causa del suo mancato intervento, un essere umano riceva danno;

2) seconda legge: un robot deve obbedire agli ordini impartiti dagli esseri umani, purché tali ordini non vadano in contrasto alla prima legge;

3) terza legge: un robot deve proteggere la propria esistenza, purché la salvaguardia di essa non contrasti con la Prima o con la seconda legge.

Le tre leggi della robotica divennero presto molto popolari tanto da spingere altri scrittori ad utilizzarle, senza però mai citarle in modo chiaro (Asimov ne era geloso e le considerava le Sue Leggi), e a far addirittura quasi sparire la narrazione e le storie di robot distruttori.

In alcuni dei suoi ultimi racconti Asimov postula l’esistenza di una quarta legge, superiore per importanza alle altre tre denominata quindi la Legge Zero (valida forse però solo per gli automi più sofisticati):

Legge Zero: un robot non può danneggiare l’umanità, né può permettere che, a causa del suo mancato intervento, l’umanità riceva danno.

A seguito dell’introduzione della Legge Zero, le tre Leggi furono modificate:

1) un robot non può recar danno a un essere umano né può permettere che, a causa del proprio mancato intervento, un essere umano riceva danno. Purché questo non contrasti con la legge zero;

2) un robot deve obbedire agli ordini impartiti dagli esseri umani, purché tali ordini non contravvengano alla legge zero e alla prima legge;

3) un robot deve proteggere la propria esistenza, purché questa autodifesa non contrasti con la legge zero, la prima legge e la seconda legge.

L’introduzione della Legge Zero solleva ancora oggi non pochi dibattiti poiché, di fatto, ammette la possibilità che un robot possa fare del male ad un essere umano qualora, in determinate circostanze, la salvaguardia dell’umanità sia l’obiettivo superiore cui tendere (anche se questo significa dover sacrificare qualche essere umano).

Il dibattito in realtà è stato già risolto dallo stesso Asimov che nel finale del romanzo “I robot e l’Impero” consente al robot Reventlov di far vivere agli abitanti della Terra, che non vogliono migrare su altri pianeti spaziali, la lenta agonia nucleare del pianeta. Una scelta che però danneggia in modo irreparabile il cervello positronico del robot.

*estratto da Asimov e le tre leggi della robotica, in AI 4 Business, 13/o8/2019